Qu’appelle-t-on imagerie aérienne et son interprétation par l’IA ?

Les systèmes aéroportés embarquant des capteurs permettent d’acquérir des observations numériques de notre planète à faible coût, sur des grandes zones possiblement difficiles d’accès (comme les environnements de montagne). Les avancées technologiques donnent lieu à des systèmes plus petits, plus légers, fournissant des observations plus précises. Dans ce projet, l’imagerie aérienne est acquise par drone et consiste en des images couleur, multispectrales (couvrant également le spectre invisible via les longueurs d’onde infrarouges), et les nuages de points 3D.

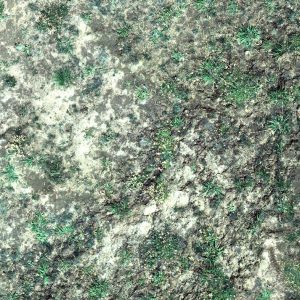

- Image du spectre visible (rouge, vert, bleu) sur la zone de Bocard

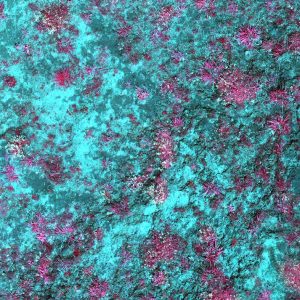

- Image multispectrale (composition en fausse couleurs avec l’infra-rouge) sur la zone de Bocard

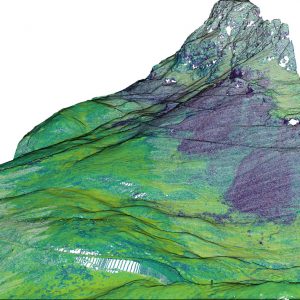

- Carte d’élévation LiDAR sur la zone de Chichoue

- Nuage de point LiDAR 3D sur la zone de Chichoue

La disponibilité croissante de masses de données de télédétection a un coût : elle nécessite des méthodes automatiques pour analyser ces données, et pour en tirer des connaissances. Récemment, ce besoin a été principalement couvert par les techniques de l’Intelligence Artificielle (IA), qui ont été utilisées avec succès dans de nombreux domaines. Lorsqu’elles sont appliquées aux images numériques, ces techniques peuvent permettre par exemple de reconnaître une scène et les objets qui la composent. Cependant, leur application aux données écologiques reste faible, sans doute du fait des nombreux verrous scientifiques qu’elle soulève. Dans ce projet, les techniques d’IA vont aider à estimer automatiquement la distribution spatiale des plantes.

Objectifs de cet axe de recherche :

L’objectif est de combiner les données aéroportées et la caractérisation in-situ des espèces dans un modèle d’apprentissage profond pour réaliser la cartographie des espèces. Nous supposons qu’en utilisant plusieurs sources dans une architecture multi-tâche, un réseau de neurones profonds sera capable d’extraire de l’information haute-résolution au delà de la cartographie usuelle d’occupation du sol fournie par les réseaux de segmentation sémantique (qui échouent généralement à extraire précisément les contours des objets). Cela permettra d’analyser et découvrir des motifs dans les interactions entre plantes à l’échelle des communautés, et d’illustrer le potential de l’IA en écologie.

Afin d’atteindre cet objectif, nous considérons les tâches suivantes : acquérir les données multispectrales ; concevoir un réseau profond capable de réaliser une segmentation sémantique à ultra-haute résolution spatiale ; apprendre à démélanger les images multispectrales afin de distinguer les différentes espèces dans des mélanges d’espèces ; coupler des informations optiques et LiDAR dans une architecture profonde multi-modale et multi-tâche ; et coupler l’apprentissage profond avec les modèles physiques pour estimer des paramètres biophysiques (par exemple caractéristiques des plantes).

Personnes les plus impliquées :

Sébastien Lefèvre, laboratoire IRISA / équipe OBELIX, Professeur à l’Université Bretagne Sud (UBS).

Thomas Corpetti, laboratoire LETG / équipe OBELIX, Directeur de recherches au CNRS.

Thomas Dewez, Chercheur au BRGM.

Benjamin Pradel et Marie Deboisvilliers, Ingénieurs à l’Avion Jaune.

Florent Guiotte, laboratoire IRISA / équipe OBELIX, Postdoc, développant des nouvelles méthodes IA pour l’imagerie ultra-haute résolution, avec l’aide de la société L’Avion Jaune.

Hoàng-Ân Lê, laboratoire IRISA / équipe OBELIX, Postdoc, développant des nouvelles méthodes IA pour le traitement de nuages de points 3D.

Réalisations déjà effectuées :

En 2020, des suivis LIDAR, photogrammétriques et d’images multispectrales haute résolution ont été menés par drones sur plusieurs périodes de l’année afin de suivre le développement de la végétation et fournir des données d’apprentissage pour la reconnaissance automatique des plantes.

Un réseau de neurones profonds apprenant un Modèle Numérique d’Élévation à partir d’un nuage de points 3D (Postdoc de Hoàng-Ân Lê) a aussi été mis en place